Internet werkt het beste als decentraal netwerk

In de nieuwe serie berichtgeving op Bouwen aan Beter kijken we naar internet, het medium en de partijen waarmee het nieuws tegenwoordig naar je toe komt. In het vorige bericht keken we reeds naar het ontstaan en de privatisering van internet.

In dit bericht kijken we naar de opbouw van ARPANET en zien we hoe de knapste koppen een robuust netwerk opzetten. Dit zijn lessen die we zullen moeten toepassen zodat we ook in de toekomst informatie en onafhankelijk nieuws over onze samenleving vrij kunnen blijven delen.

Opdracht: Bouw een robuust netwerk

In de jaren ’60 bedacht men dat voor het uitvoeren van overheidstaken (en uiteraard: oorlog) het verzamelen en gebruiken van informatie een belangrijke activiteit is. Informatie is macht en ook voor het aansturen van het leger is communicatie benodigd. Robuuste informatievoorziening werd terecht gezien als een belangrijk succescriterium voor continuity of government – het blijven uitvoeren van overheidsactiviteiten tijdens een oorlog.

De opdracht van het Amerikaanse Ministerie van Defensie: Bouw een netwerk om onze databases eenvoudig toegankelijk te maken en zorg dat het mogelijk wordt om manschappen en materieel verspreid over de planeet aan te sturen. Eén van de eisen aan dit nieuwe netwerk was dat het tegen een stootje moest kunnen.

Onder dreiging van het communisme werd een netwerk uitgedacht dat bestand was tegen een atoomoorlog. Het werd daarbij snel duidelijk dat als er één grote, centrale computer en database is, gelegen (bijvoorbeeld) in Utah, waarop iedereen aansluit, er een erg gevoelige oplossing ontstaat. Eén bom op het netwerkcentrum en Amerika is vleugellam. Dat idee gaat het dus niet worden.

Het ARPANET van de vele verbindingen

De oplossing voor dit probleem was een gedecentraliseerd netwerk, waarbij computers via meerdere wegen op elkaar zijn aangesloten. Internet bestaat uit een grote verzameling netwerkverbindingen (weergegeven als lijntjes). Dit zijn een soort dure telefonieverbindingen die het elk mogelijk maken te communiceren tussen twee knooppunten (weergegeven als blokjes).

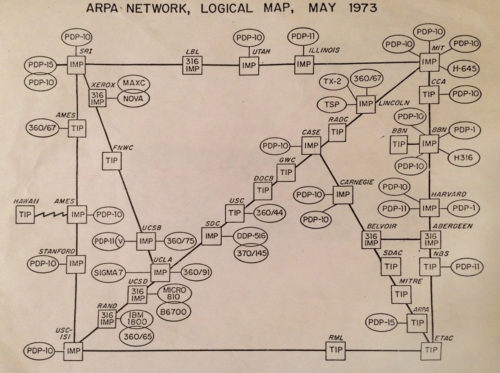

In de afbeeldingen uit 1973 (zie boven aan dit bericht) zie je een wat vierkant ogend netwerk van op elkaar aangesloten knooppunten. Bedenk dat het wegvallen van een deel van dit netwerk resulteert in een situatie waarin alle nog bestaande blokjes bereikbaar blijven via een ander lijntje. Zo niet linksom, dan wel rechtsom, dan wel door het midden.

De magie zit hem in de knooppunt blokjes: de Interface Message Processor (IMP) en Terminal Interface Processor (TIP) computers. Deze computers communiceren met elkaar middels een gedetailleerd omschreven technische taal. Losse, lokale computers sluiten elk individueel aan op een IMP of TIP en daarna kan je direct gegevens uitwisselen met alle overige aangesloten computers van welk merk en type dan ook.

De IMP en TIP knooppunten werken als doorgeefluiken voor informatie. Ze bevatten intelligentie over hoe ontvangen informatie het beste doorgestuurd kan worden. Routers, zoals deze intelligente knooppunten tegenwoordig heten, schakelen bij uitval van één lijntje (route) automatisch over naar een ander lijntje (route). En er is nagenoeg altijd wel een route te vinden door het netwerk naar het gewenste doel. Dit zorgt voor een robuust netwerk dat goed beschermd is tegen aanval en uitval.

Een voorbeeld

Een voorbeeld. Verstuur een e-mail van militair onderzoekslab RAND (linksonder) naar het Pentagon (rechtsonder). Dit berichtje passeerde in 1980 de University of Southern California (USC) en Fort Bragg voordat het aankwam bij de bestemming. Werkt die route echter niet vanwege uitval? Dan gaat het verkeer bijvoorbeeld bovenlangs over Utah, Wright Patterson Airforce Base (WPAFB) en Carnegie Mellon University (CMU).

Deze slimme knooppunten zijn de belangrijke uitvinding van ARPANET. En dat idee is goud waard. Voor internet, maar ook voor ons én onze wens om ook in de toekomst onafhankelijke inzichten en nieuwsgeving te kunnen blijven delen en lezen. Ook ons nieuws zullen we dus slim naar elkaar moeten brengen over internet, willen we dat kunnen beschermen tegen toekomstige aanval en uitval.

Hypertext en het World Wide Web (www)

Het internet uit de jaren ’70 en ’80 bestond onder andere uit e-mail en bestandsuitwisseling maar de tegenwoordig bekende websites werden slechts realiteit vanaf eind 1990. En juist die uitvinding resulteerde in de latere jaren ’90 in de explosieve groei van internet zoals we dat nu kennen.

Bij het wereldwijde web hoort uiteraard weer een prachtige militaire achtergrond. De technische naam van het web is hypertext. Het idee achter hypertext is te traceren naar de Amerikaanse militaire insider en kopstuk Vannevar Bush. Deze man heeft heel wat teweeg gebracht in Amerika, waaronder in 1945 het idee dat je tekst in computers op een slimme en interactieve manier aan elkaar kan verbinden met hyperlinks (referenties, links).

Via Ted Nelson, die de naam hypertext bedacht, belandde dit idee bij Tim Berners-Lee die de technische realisatie daarvan uitwerkte. De eerste website zoals we die nu kennen werd op 20 december 1990 feit bij CERN, de website van Tim Berners-Lee.

Een waardevol internationaal web van informatie

Een eigen webpagina werd al snel een standaarduitrusting voor het publiceren van onderzoeksresultaten en -informatie van onderzoekers bij universiteiten. Al deze data werd niet verzameld op één punt, maar verspreid op de diverse werklocaties over het gehele netwerk.

Dit geldt ook voor gebruikers thuis. Al snel kreeg je in de jaren ’90 als klant bij je internetabonnement thuis ook automatisch ruimte op een lokale server voor een eigen webpagina. Ziggo bood dit standaard aan tot 2015. Bij KPN en XS4ALL kan dit nog steeds.

Wanneer iedere gebruiker van internet zelf zijn informatie publiceert op zijn eigen toegangspunt, heb je een waardevol en goed verspreid netwerk van informatie gecreëerd. Dan ontstaat een werkelijk internationaal informatienetwerk: vrij toegankelijk voor iedereen, decentraal verspreid over de gehele planeet. Dat is het wereldwijde web zoals het bedoeld is. En dat is uiteraard niet wat het nu is geworden.

Conclusie

Internet werd een succes door decentralisatie: computers die verspreid over de planeet onderling berichten uitwisselen. De decentraliteit van internet werd afgelopen jaren echter grondig ongedaan gemaakt. Alles werd gecentraliseerd in de handen van een zeer klein aantal militaire aannemers. Al onze data en communicatie als ook de toegang daartoe, werd toegeëigend door bedrijven als Google, Twitter, Amazon, Microsoft en Facebook. Ook onze toegang tot het nieuws wordt nu gekanaliseerd én gecensureerd door deze partijen. Hun plan voor de toekomst is deze grip op ons nieuws verder uit te breiden. Daar gaan we binnenkort uiteraard nog even beter naar kijken.

De mogelijkheidsdenker ziet in dit bericht uiteraard ook de oplossing voor het probleem van een gecentraliseerd en gecensureerd internet beschreven. Hoe kunnen we vrije informatie blijven uitwisselen tijdens deze ‘koude oorlog’ tegen eerlijke nieuwsvoorziening? Terug naar het originele ontwerp! Als het een atoomoorlog aan kan, dan kan het de censuur van de EU, het groot mediabedrijf, Google en Facebook uiteraard ook aan.

De gewenste oplossing voor ons nieuwsplatform is het herintroduceren van decentralisatie van communicatie en de verspreiding van opslag. Hiervoor zijn prachtige mogelijkheden beschikbaar gebaseerd op gestandaardiseerde, open technologie. Dit resulteert in oplossingen die niet (eenvoudig) toegeëigend of geblokkeerd kunnen worden. En ook daar gaan we in het volgende bericht verder naar kijken.

We hebben een plan ontwikkeld, en er is veel mogelijk, maar dat kunnen we niet alleen. Jouw steun is daarvoor benodigd.